Transformer在nlp词向量预训练中的应用

1268×714

Bert、gpt 2等预训练模型这么多,用什么预训练框架来跑这些模型? 智源社区

1080×606

原生bert的训练和使用总结 知乎

1192×914

预训练模型 Bert 知乎

600×327

Bert预训练的任务mlm和nsp 知乎

600×765

Bert 2017:预训练 微调的模式 知乎

951×897

Transformer究竟是什么?预训练又指什么?bert

913×393

关于bert预训练模型,你想知道的都在这 墨天轮

720×418

Bert原理解读及huggingface Transformers微调入门 知乎

600×303

Bert:通过双向transformer结构预训练强化语言理解 知乎

1440×806

Bert模型的微调,如何固定住bert预训练模型参数,只训练下游任务的模型参数? 知乎

1227×804

【transformer系列】bert模型与代码解析 知乎

1676×1023

Bert预训练模型系列总结(上) 轻识

1080×318

Cv和nlp中的无监督预训练生成式bertigpt和判别式simclrsimcse 知乎

1080×252

Bert系列:bert(bidirectional Encoder Representations From Transformers)原理

2404×1664

预训练语言模型:bert 家族的若干变体 知乎

500×283

预训练语言模型中transfomer模型、自监督学习、bert模型概述(图文解释) 阿里云开发者社区

517×453

预训练语言模型中transfomer模型、自监督学习、bert模型概述(图文解释) 阿里云开发者社区

预训练语言模型中transfomer模型、自监督学习、bert模型概述(图文解释) 阿里云开发者社区

788×293

Transformer之bert预训练语言解析的方法是什么 开发技术 亿速云

773×519

Nlp中的预训练语言模型总结单向模型、bert系列模型、xlnet 知乎

1756×1198

预训练语言模型的发展历程 知乎

590×537

从零实现bert中的两个预训练任务(下) 知乎

1380×776

全面改进transformer类预训练模型,自然语言任务超越bert 自然语言处理 炼数成金 Dataguru专业数据分析社区

1080×608

中文transformer(bert,gpt,t5等)预训练模型权重word文档在线阅读与下载免费文档

1730×1495

Bert预训练模型的演进过程!附代码 走看看

720×405

Nlp中的预训练语言模型总结单向模型、bert系列模型、xlnet 知乎

Nlp中的预训练语言模型总结单向模型、bert系列模型、xlnet 知乎

1440×934

如何从零开始训练bert模型? 知乎

1770×1354

Attention、self Attention、transformer和bert模型基本原理简述笔记 Csdn博客

993×969

怎么学习pytorch的bert预训练模型? 知乎

1228×1148

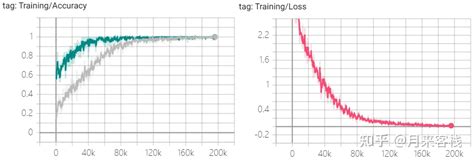

如何从零开始训练bert模型? 知乎

如何从零开始训练bert模型? 知乎

2026×684

如何从零开始训练bert模型? 知乎

如何从零开始训练bert模型? 知乎

1214×1118

Bert 理解上下文的语言模型通过bert预训练获取日志事件模版上下文语义 Csdn博客

1090×654

一文看懂transformer到bert模型 Csdn博客

1080×578

从word Embedding到bert模型—自然语言处理中的预训练技术发展史 知乎

1268×714

Transformer、bert总结bert和transformer的关系 Csdn博客

962×581